Il ministro della Tecnologia Paul Scully ha messo in guardia dall'esagerare i potenziali pericoli dell'intelligenza artificiale (IA) per l'umanità sminuendo i suoi potenziali benefici.

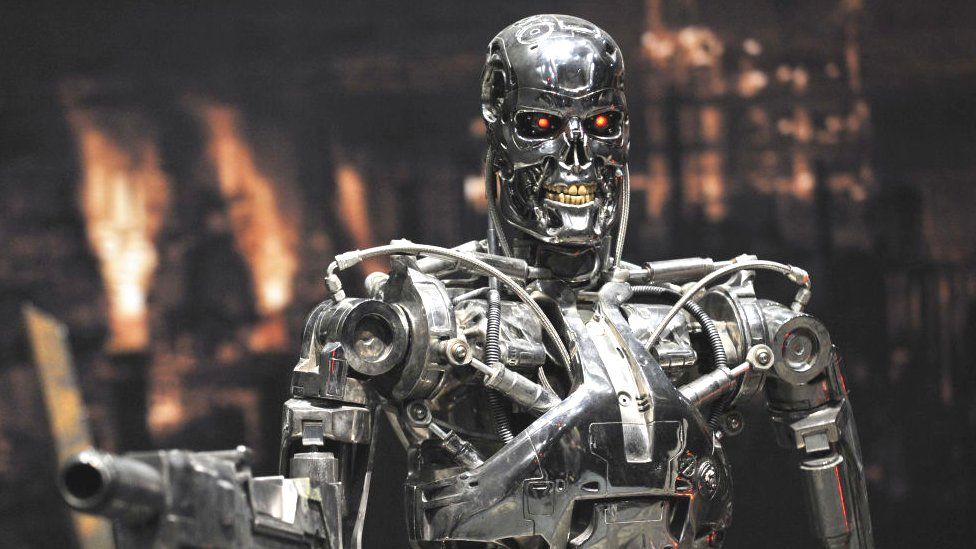

Un sistema maligno di IA "Skynet", intenzionato a sradicare l'umanità, è immaginato nella serie di film di fantascienza The Terminator.

La scorsa settimana diverse aziende hanno lanciato avvertimenti sul fatto che l'IA potrebbe essere pericolosa per le persone.

Preparandosi a visitare gli Stati Uniti, il Primo Ministro Rishi Sunak parlerà di una serie di argomenti, tra cui l'IA.

L'intelligenza artificiale (IA) si riferisce alla capacità di un computer di svolgere compiti che tipicamente richiedono l'intelligenza umana.

C'è stato un "punto di vista distopico sull'IA che possiamo seguire qui. È presente anche un punto di vista utopico. Alla TechUK Tech Policy Leadership Conference di Westminster, Scully ha dichiarato che entrambi sono concepibili.

Una distopia è un'ambientazione fittizia in cui tutto è il peggio possibile.

"Se si discute solo dell'estinzione dell'umanità a causa di uno scenario rocambolesco in stile Terminator, si perderanno di vista tutti gli effetti positivi che l'IA sta già producendo, come la mappatura delle proteine per aiutare la ricerca medica e la lotta al cambiamento climatico.

Tutte queste cose sono già state fatte dall'IA e non potranno che essere migliorate". "Secondo Marc Warner, membro dell'AI Council, un gruppo di esperti istituito per consigliare il governo, potrebbe essere necessario vietare le IA più potenti. Warner ha rilasciato questa dichiarazione a BBC News la scorsa settimana.

Ma ha affermato che le "IA ristrette" create per scopi specifici, come i programmi che scansionano le immagini mediche per individuare eventuali tumori, dovrebbero essere soggette alle stesse normative della tecnologia attuale.

Non siamo compiaciuti dei potenziali rischi dell'IA, ma offre anche opportunità significative, ha dichiarato il portavoce del Primo Ministro in risposta ai rapporti sui potenziali rischi che la tecnologia potrebbe comportare.

Senza guardrail in atto, non possiamo andare avanti con l'IA. "Secondo Lucy Powell, segretario ombra alla cultura per il Labour, c'è "un livello di isteria in corso e che certamente sta dominando il dibattito pubblico in questo momento, ma ci sono opportunità reali con lo sviluppo di una tecnologia come l'IA".

"Ma dobbiamo pensare molto attentamente ai rischi, assicurarci di avere una buona regolamentazione in atto", ha continuato. "

È fondamentale che gli effetti dell'IA siano percepiti da tutti e che "non vadano solo ai grandi colossi tecnologici degli Stati Uniti, come è successo nell'ultima rivoluzione tecnologica". In precedenza, la Powell aveva dichiarato al Guardian di ritenere che l'IA dovesse essere autorizzata in modo simile a quanto avviene per le droghe o l'energia nucleare, che hanno entrambi un'autorità di regolamentazione specifica.

Potrebbe essere necessario un'autorità di regolamentazione globale per l'IA altamente intelligente, simile all'Agenzia internazionale per l'energia atomica, secondo un recente post sul blog dell'azienda di IA OpenAI.

Brad Smith, presidente di Microsoft, ha dichiarato durante lo stesso evento che le IA più potenti potrebbero richiedere permessi di sicurezza per operare.

"Un modello deve superare un esame di sicurezza di qualche tipo prima di poter essere distribuito". "Smith ha sostenuto che sarebbe preferibile un unico modello di regolamentazione e una cooperazione globale. Il Regno Unito e gli Stati Uniti, secondo lui, sono in una buona posizione per cooperare quando si tratta di sicurezza informatica e nazionale.

In occasione dell'evento, ha dichiarato ai giornalisti che Microsoft non si unirà alla "parata della paura", aggiungendo che sarebbe preferibile abbassare i toni della retorica e concentrarsi maggiormente sulle questioni urgenti da affrontare.

Altri esperti hanno concordato sul fatto che concentrarsi su scenari disastrosi da fantascienza serve a distogliere l'attenzione dai problemi urgenti dell'IA, come la possibilità di pregiudizi negli algoritmi dovuti alla razza o al genere.